访问数:2203

访问数:2203

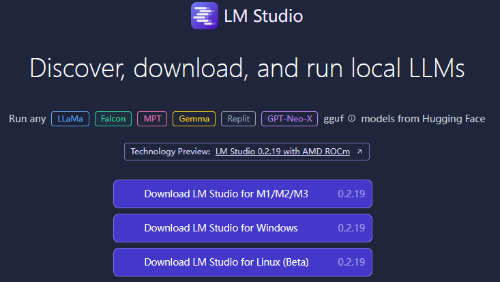

LM Studio 是一个快速本地部署大模型的软件。

支持LLaMa、Falcon、MPT、Gemma、Replit、GPT-Neo-X等支持gguf的模型。

解释:gguf是一种文件格式,任何可以将其架构转换为gguf格式的模型,都能在LM Studio中运行。

当前版本:0.2.20

软件下载和安装

下载地址:从官网就可以直接下载,不过稍慢一点。

安装:LM Studio 在 Winidows 上下载后,不需要安装即可直接运行。

运行内存:建议8G以上。

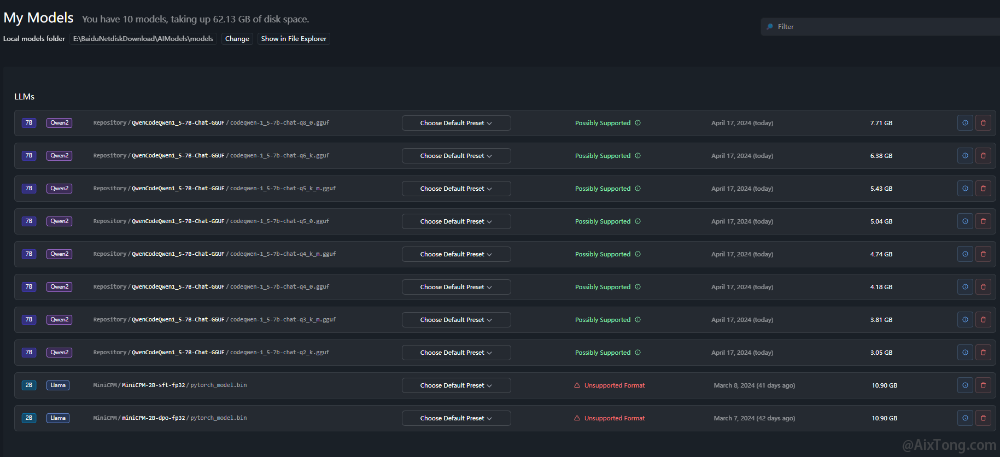

修改模型保存路径:运行后,第一步应先修改模型的保存路径,因为模型文件都是比较大的,一般都在几个G。点击左侧工具按钮的最下方一个(文件夹图标),右侧显示当前默认模型目录下的内容。点击上方的change按钮修改路径。

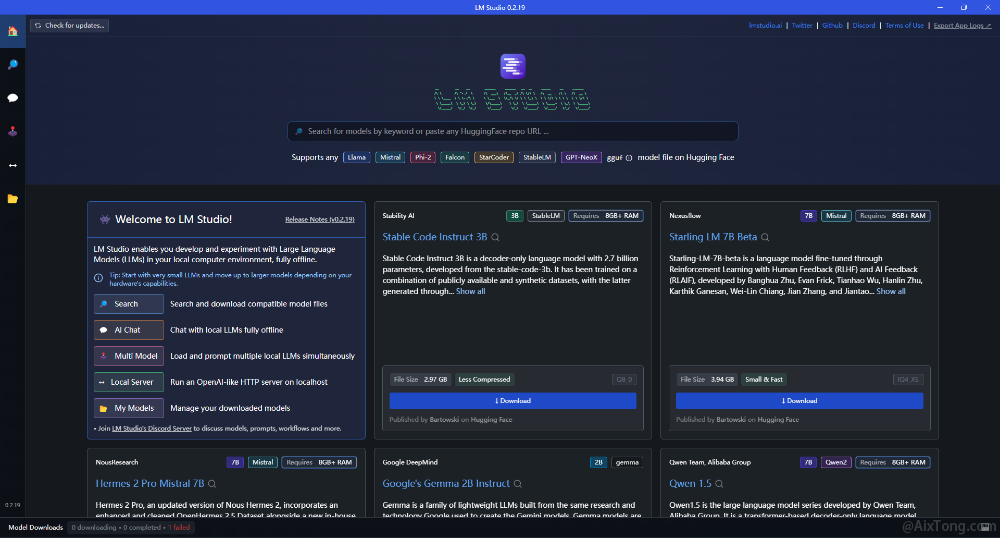

软件界面

打开软件后,首页除了搜索和欢迎内容,其余就是目前可用的大模型了。常见的千问大模型也在其中。

下载模型

你可以在首页下载模型,也可以在搜索页搜索和下载。但国内是无法访问Hugging Face的,怎么办?在出错界面复制链接,修改后手动下载。

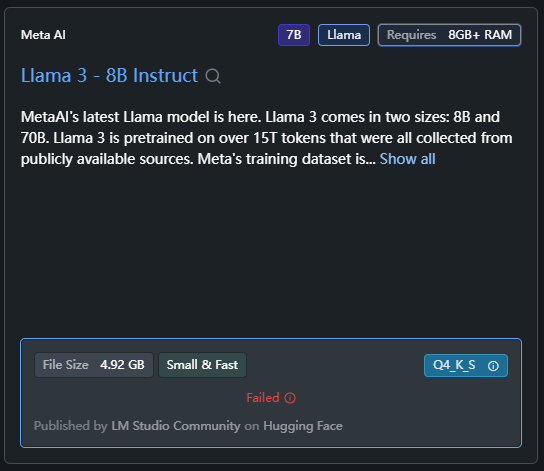

如下模型是0.2.20版本新增的模型,点击下载后出错:

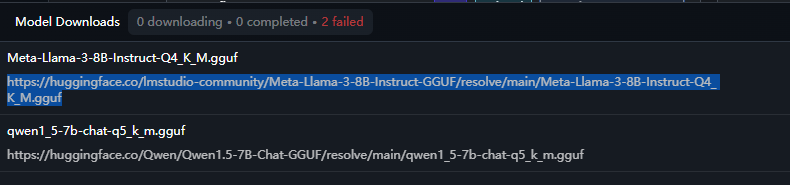

点击红色的错误信息,展开错误详情:

复制链接,并将 https://huggingface.co 替换为 https://hf-mirror.com 通过浏览器进行下载,并保存到LM Studio的模型目录下,就可以正常使用了。

注意目录结构:

--models

----Publisher

--------Repository

------------yourModelDir

在Respository下放你的模型文件目录。这样就可以了。

模型文件识别后,如上图所示,显示绿色的,表示是LM Studio支持的格式,而红色的是不支持的格式。

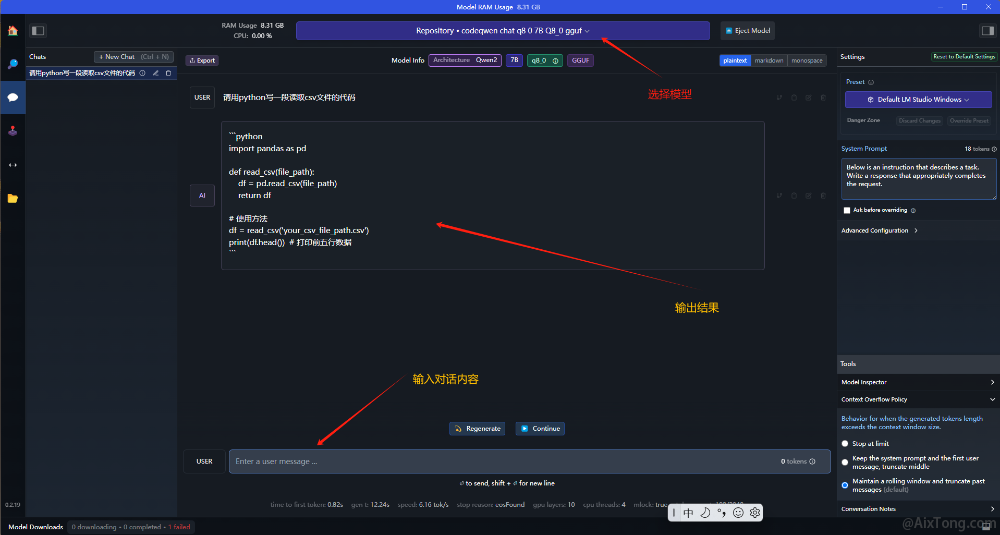

在LM Studio中测试模型

点击AI Chat图标,打开对话界面。在最上面的下拉框中,选择一个模型,加载完成后就可以使用了。

上述使用了千问的7B模型。

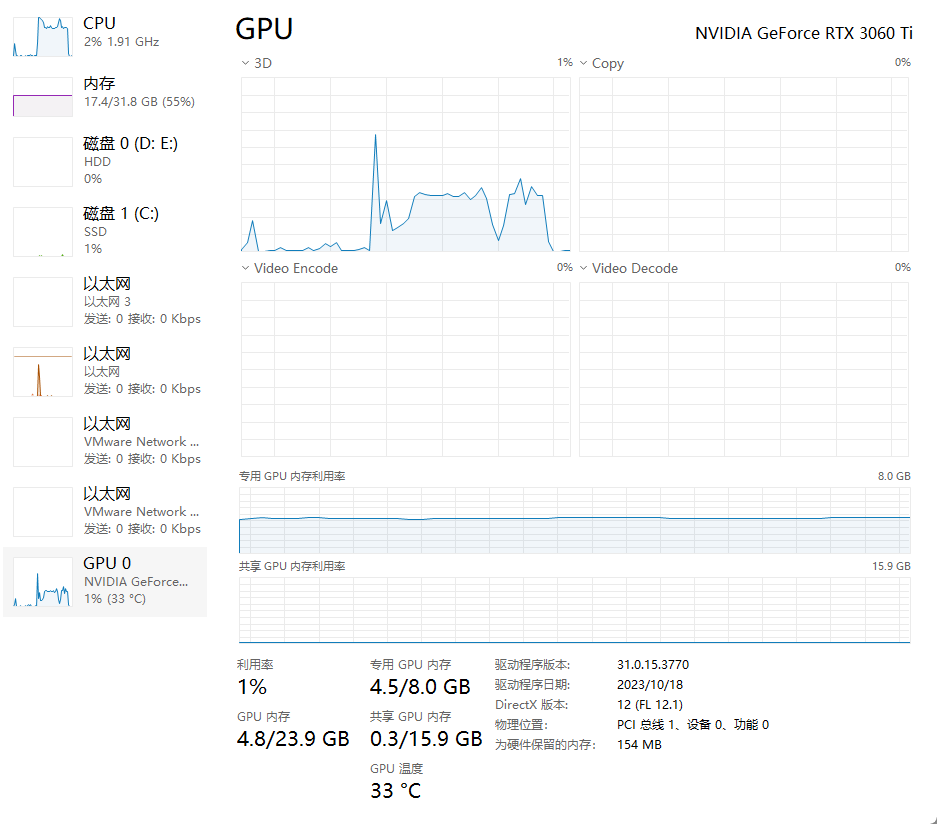

运行过程中,你可以通过Windows的任务管理器查看资源使用情况。

从上面图中可见,还是挺费资源的。不过这是模型的原因,并不是LM Studio的资源占用。

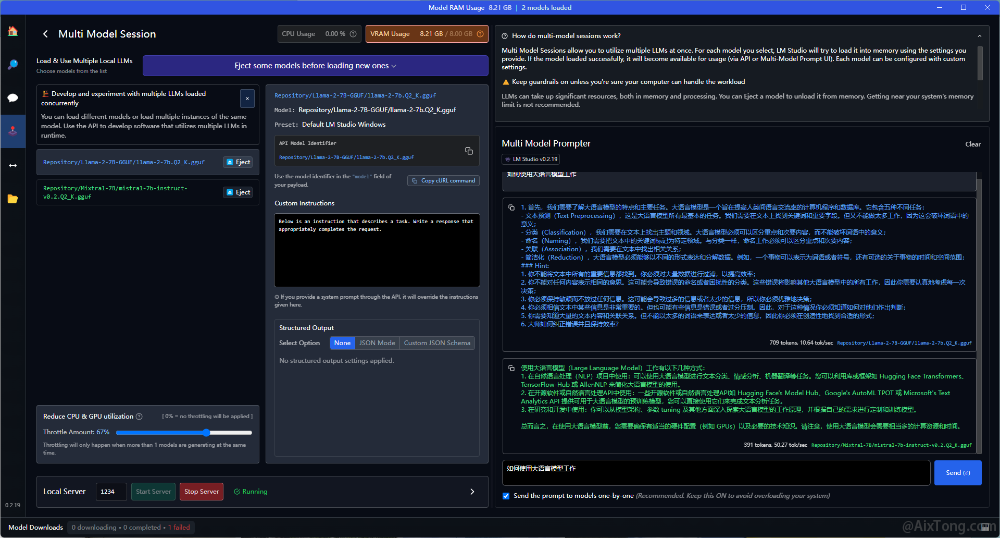

多模型会话

多模型会话是指加载多个模型,在提问一个问题时,多个模型都进行回复(对话),你可以比较一下哪个模型的回答更好一些。当然,要运行多模型会话,你需要更高的资源。

如下图,加载了两个模型,一个是千问的7B模型,一个是mistral 7B模型,运行结果:

左侧显示了加载的多个模型,右侧为同一个问题的不同模型回答结果。