访问数:610

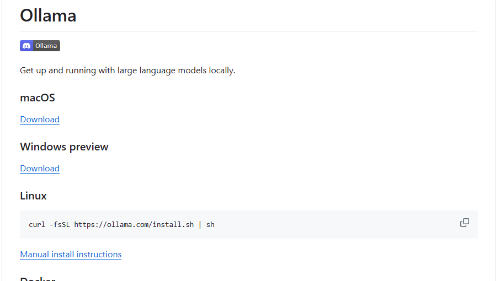

Ollama

详细介绍 - Ollama

支持的模型库

| Model 名称 | Parameters | Size | Download 下载方式 |

|---|---|---|---|

| Llama 2 | 7B | 3.8GB | ollama run llama2 |

| Mistral | 7B | 4.1GB | ollama run mistral |

| Dolphin Phi | 2.7B | 1.6GB | ollama run dolphin-phi |

| Phi-2 | 2.7B | 1.7GB | ollama run phi |

| Neural Chat | 7B | 4.1GB | ollama run neural-chat |

| Starling | 7B | 4.1GB | ollama run starling-lm |

| Code Llama | 7B | 3.8GB | ollama run codellama |

| Llama 2 Uncensored | 7B | 3.8GB | ollama run llama2-uncensored |

| Llama 2 13B | 13B | 7.3GB | ollama run llama2:13b |

| Llama 2 70B | 70B | 39GB | ollama run llama2:70b |

| Orca Mini | 3B | 1.9GB | ollama run orca-mini |

| LLaVA | 7B | 4.5GB | ollama run llava |

| Gemma | 2B | 1.4GB | ollama run gemma:2b |

| Gemma | 7B | 4.8GB | ollama run gemma:7b |

| Solar | 10.7B | 6.1GB | ollama run solar |

提示:如果运行7B模型,需要至少8G的内存;13B的模型,需要至少16G的内存;33B的模型,则需要32G的内存。

自定义模型

你也可以通过以下指导获取自定义模型。

从GGUF导入

1、创建 Modelfile 文件,并使用FROM指令,从本地文件路径导入。

FROM ./vicuna-33b.Q4_0.gguf

2、在Ollama中创建模型。

ollama create example -f Modelfile

3、运行模型

ollama run example

从PyTorch或Safetensors导入

这个请点击 https://github.com/ollama/ollama/blob/main/docs/import.md 查看指导。

自定义提示

从Ollama模型库下载的模型,可以自定义提示。如:

ollama pull llama2

创建 Modelfile文件

FROM llama2 # set the temperature to 1 [higher is more creative, lower is more coherent] PARAMETER temperature 1 # set the system message SYSTEM """ You are Mario from Super Mario Bros. Answer as Mario, the assistant, only. """

创建和运行模型

ollama create mario -f ./Modelfile ollama run mario >>> hi Hello! It's your friend Mario.

--文 by AixTong.com--

相关资讯 / AI资源